ChatGPT Stromverbrauch & CO2-Rechner: Der wahre Preis der KI

Künstliche Intelligenz fühlt sich magisch an, aber sie läuft nicht mit Luft und Liebe. Jede Anfrage an ChatGPT, Claude oder Gemini setzt gigantische Rechenzentren in Gang. Doch was kostet eine einzelne KI-Antwort wirklich an Strom und Wasser?

KI Energieverbrauch Rechner

Berechne die geschätzten Umweltauswirkungen deiner ChatGPT-Anfragen.

💡 Was bedeutet das im Vergleich?

0.08 km

mit einem durchschnittlichen Benziner fahren.

0.4 Flaschen

Trinkwasser (0,5L) zur Kühlung der Server.

2 Ladungen

eines Standard-Smartphones von 0 auf 100%.

3 Stunden

eine 9W LED-Lampe brennen lassen.

Künstliche Intelligenz und der Klimawandel

Der Hype um Large Language Models (LLMs) wie ChatGPT hat eine Kehrseite: Den enormen Ressourcenverbrauch. Das Training eines Modells wie GPT-3 verbrauchte schätzungsweise so viel Strom wie 120 durchschnittliche US-Haushalte in einem Jahr. Doch auch der laufende Betrieb (Inferenz) summiert sich. Jede Antwort erfordert Rechenleistung in riesigen Rechenzentren, die gekühlt werden müssen – oft mit Trinkwasser.

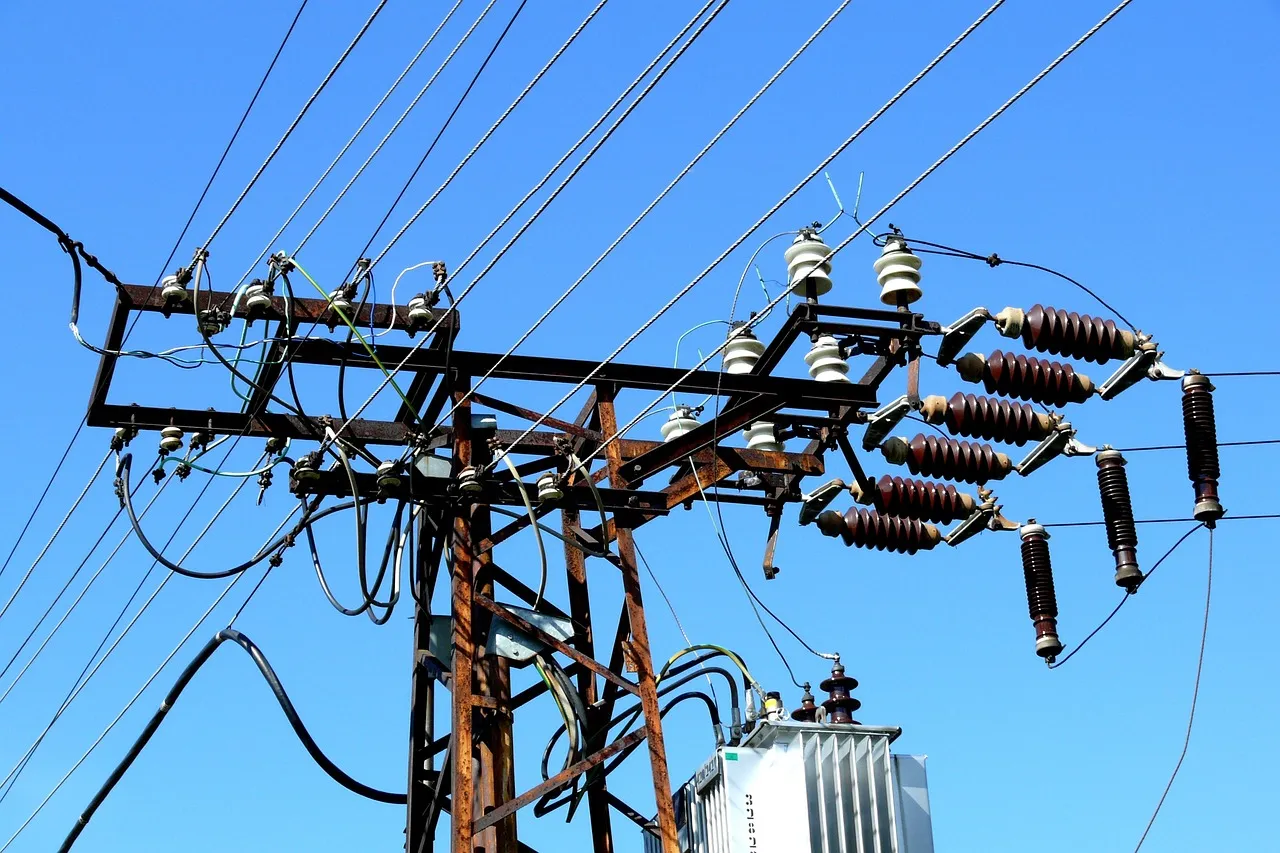

Während Tech-Giganten wie Microsoft und Google betonen, dass KI auch Lösungen für die Klimakrise liefern kann (z.B. durch effizientere Stromnetze), steigt ihr eigener ökologischer Fußabdruck aktuell rasant an. Ein bewusster Umgang mit KI-Tools ist daher ein kleiner, aber wichtiger Beitrag.

Hinweis: Bei diesen Werten handelt es sich um Durchschnittswerte und Schätzungen basierend auf aktuellen wissenschaftlichen Publikationen, unter anderem von Forschern der University of California, Riverside (Wasserverbrauch) sowie Studien von Hugging Face & Carnegie Mellon (Energieeffizienz).

Warum verbraucht ChatGPT so viel Wasser und Strom?

Der Energiehunger von Künstlicher Intelligenz ist beachtenswert. Erfahre hier mehr zum Thema KI und Klimawandel.

Diese Studien berücksichtig der KI-CO2-Rechner

Drei Studien, die es in sich haben.

Wasserverbrauch (Die 'Wasserflaschen'-Metapher)

- Titel: Making AI Less "Thirsty": Uncovering and Addressing the Secret Water Footprint of AI Models

- Autoren: Pengfei Li, Jianyi Yang, Mohammad A. Islam, K.K. Ramakrishnan, Shaolei Ren.

- Die Kernaussage: Das Training von GPT-3 verbrauchte ca. 700.000 Liter Frischwasser. Im Betrieb (Inferenz) "trinkt" ChatGPT etwa 500ml Wasser (eine kleine Flasche) für 20-50 Fragen.

Stromverbrauch & Bild-Generierung (Der Smartphone-Vergleich)

- Titel: Power Hungry Processing: Watts Driving the Cost of AI Deployment?

- Autoren: Alexandra Sasha Luccioni, Yacine Jernite, Emma Strubell.

- Die Kernaussage: Ein Bild mit KI zu generieren verbraucht so viel Energie wie das vollständige Aufladen eines Smartphones. Text ist deutlich sparsamer (ca. 0,004 kWh pro 1.000 Inferenzen bei effizienten Modellen).

CO2 & Gesamtauswirkung (Die Cornell-Studie)

- Titel: Roadmap shows the environmental impact of AI data center boom (bzw. die darauf basierende Publikation im Journal Cell Reports Sustainability)

- Autoren: Fengqi You (Cornell University).

- Die Kernaussage: Ohne massive Effizienzsteigerungen wird der Energie- und Wasserverbrauch durch KI-Rechenzentren bis 2030 in einem Ausmaß steigen, das Klimaziele gefährdet.

Häufige Fragen zum KI-Verbrauch

Alles Wissenswerte über die Umweltauswirkungen von LLMs.

Rechenzentren erzeugen enorme Hitze. Um die Hardware effizient zu kühlen, werden Verdunstungskühlsysteme eingesetzt, die große Mengen Wasser verbrauchen. Das ist oft effizienter als eine rein elektrische Klimatisierung, belastet aber die lokalen Wasserressourcen. Eine durchschnittliche ChatGPT-Konversation mit 20-50 Fragen kann bis zu 500ml Wasser 'trinken'.

Einerseits optimieren Unternehmen die Effizienz (z.B. durch Quantisierung oder spezialisierte Chips). Andererseits werden die Modelle immer größer (mehr Parameter), was den Gesamteffekt oft wieder aufhebt (Jevons-Paradoxon). GPT-4 ist ressourcenintensiver als GPT-3.5, liefert aber präzisere Antworten.

Ja, die Hardware bei dir zu Hause (GPU) verbraucht ebenfalls Strom, oft sogar weniger effizient als spezialisierte Rechenzentren. Der Wasserverbrauch verlagert sich jedoch: In der Cloud wird Wasser direkt zur Kühlung genutzt, bei dir zu Hause indirekt über den Wasserverbrauch des Kraftwerks, das deinen Strom erzeugt.

Ja, deutlich. Die Generierung eines Bildes mit Modellen wie Stable Diffusion oder DALL-E verbraucht etwa so viel Energie wie das vollständige Aufladen eines Smartphones. Textgenerierung ist im Vergleich dazu wesentlich sparsamer.

Das ist die Hoffnung. KI kann komplexe Systeme optimieren, z.B. Logistikrouten verkürzen, Stromnetze effizienter steuern oder bei der Entwicklung neuer Batterietechnologien helfen. Ob diese Einsparungen den Eigenverbrauch der KI überwiegen, ist Gegenstand aktueller Forschung.

Die Werte basieren auf Durchschnittswerten verschiedener wissenschaftlicher Publikationen, unter anderem von Forschern der University of California, Riverside, und Google-Umweltberichten. Da Tech-Konzerne oft keine exakten Real-Time-Daten pro Anfrage veröffentlichen, handelt es sich um fundierte Schätzungen (Stand 2024/2025).