Vibe-Coding: Warum blindes KI-Vertrauen dein SaaS gefährdet

Vibe-Coding: Warum blindes KI-Vertrauen dein SaaS gefährdet

In 30 Sekunden

- Die Gefahr: "Vibe-Coding" ersetzt tiefes technisches Verständnis durch blindes Vertrauen in KI-Prompts – ein Rezept für instabile und unsichere Software.

- Die Haftung: Neue EU-Gesetze (CRA) beenden die Ära von "Software as is" – du haftest künftig für Sicherheitslücken, egal ob Mensch oder KI sie geschrieben hat.

- Die Architektur: KI optimiert auf statistische Wahrscheinlichkeit, nicht auf logische Integrität; sie baut funktionierende Fassaden mit offenen Hintertüren (Hardcoded Secrets, fehlende Validierung).

- Die Lösung: Werde vom "Viber" zum Architekten. Nutze Security-Scanner, das Vier-Augen-Prinzip und TDD, um KI-Code wie den Entwurf eines unzuverlässigen Praktikanten zu behandeln.

Vibe-Coding: Warum dein blindes Vertrauen in die KI dein Business gefährdet

Was ist Vibe-Coding?

"Vibe-Coding" beschreibt den Trend, Software fast ausschließlich durch KI-Prompts zu erstellen, ohne den generierten Code im Detail zu verstehen oder zu prüfen. Man "vibt" sich zum Ergebnis: Solange es im Browser gut aussieht, wird es deployed.

Du tippst einen Satz, die KI liefert die Lösung. Es fühlt sich mühelos an. Doch genau hier beginnt die Gefahr. Vibe-Coding tauscht tiefes Verständnis gegen oberflächliche Geschwindigkeit. Du baust Funktionen, die du selbst nicht mehr vollumfänglich durchdringst.

Die KI kennt keinen Kontext. Sie versteht deine spezifische Geschäftslogik nicht. Sie würfelt Codefragmente zusammen, die im Testlauf glänzen, aber unter realer Last zerbrechen. Dein Backend wird zur Blackbox. Sicherheitslücken werden zum Standard, weil niemand mehr die Architektur systematisch prüft.

Wer unkritisch vertraut, handelt fahrlässig. Ein Algorithmus haftet nicht für Datenlecks. Er zahlt keine Strafen bei DSGVO-Verstößen. Wenn Projekte kollabieren, liegt das selten an der Technik selbst, sondern am Verzicht auf menschliche Sorgfalt. Dein Business steht plötzlich auf einem Fundament aus statistischen Wahrscheinlichkeiten.

Achtung: Das Ende von 'Software as is' (EU CRA)

(dies stellt keine Rechtsberatung dar)

Die Zeiten, in denen sich Software-Hersteller mit Klauseln wie "provided as is" aus der Verantwortung stehlen konnten, sind vorbei. Mit dem EU Cyber Resilience Act (CRA) und der Aktualisierung der Produkthaftungsrichtlinie wird Software rechtlich bald wie ein physisches Produkt behandelt (wie ein Auto oder Toaster).

Was das für dich bedeutet:

-

Haftung für KI-Code: Wenn deine App durch eine Sicherheitslücke Schaden anrichtet (z.B. Datenleck), haftest du als "Hersteller" – egal, ob du, ein Freelancer oder ChatGPT den Code geschrieben hat.

-

Update-Pflicht: Du bist gesetzlich verpflichtet, Sicherheitslücken für die gesamte erwartete Lebensdauer des Produkts unverzüglich zu schließen.

-

Meldepflicht: Aktiv ausgenutzte Schwachstellen müssen binnen 24 Stunden an die Behörden gemeldet werden.

Wer Vibe-Coding betreibt und unsicheren Code shippt, riskiert künftig nicht nur seinen Ruf, sondern Bußgelder in Millionenhöhe.

Der Fall der Tea App: Wenn ein 'sicherer Ort' zum Paradies für Stalker wird

Die „Tea App“ lieferte 2025 die Blaupause für dieses Scheitern. Das Versprechen: Ein geschützter Raum für Frauen. Doch im Sommer 2025 kollabierte dieses Kartenhaus. Über 72.000 hochsensible Bilder – Selfies, Führerscheine, Reisepässe – lagen schutzlos auf einer falsch konfigurierten Datenbank.

Der wahre Abgrund offenbart sich hinter den Kulissen: In einem Interview gab der Gründer offen zu, selbst nicht coden zu können. Die App wurde von externen Entwicklern zusammengezimmert. Hier sehen wir Vibe-Coding in seiner reinsten Form:

- Ein Gründer „vibt“ eine Vision.

- Er versteht die Architektur nicht.

- Er delegiert die Verantwortung für das Unsichtbare.

Das Ergebnis? Über eine Million privater Konversationen wurden öffentlich. Die App scheiterte an der Arroganz, Softwarebau als reines Management-Produkt zu verstehen. Sicherheit ist kein Vibe. Wer ein Haus für die sensibelsten Daten baut, ohne zu wissen, wie ein Schloss funktioniert, baut kein Produkt – er baut eine Haftungsfalle.

Die unsichtbare Gefahr: Warum 'es funktioniert' nicht reicht

Wenn du eine KI bittest, eine Anwendung zu entwerfen, liefert sie dir ansprechende Interfaces. In diesem Moment schnappt die Falle zu. Du verwechselst Sichtbarkeit mit Stabilität.

Sprachmodelle optimieren auf Wahrscheinlichkeit, nicht auf logische Integrität. Ein generiertes Backend wirkt professionell, lässt aber oft die Hintertür offen:

- Fehlende Validierung: Eingabefelder werden ungeprüft an die Datenbank gereicht.

- Mangelhaftes Hashing: Passwörter landen im Klartext oder schwach verschlüsselt in der DB.

- Logik-Lücken: Die KI antizipiert keine böswilligen Nutzer (Edge Cases).

Ein Hacker interessiert sich nicht für deine Ästhetik. Er sucht die logische Inkonsistenz. „Es funktioniert“ beschreibt lediglich den Zustand der Fassade. Vibe-Coding ersetzt kein Sicherheitsaudit; es maskiert lediglich dessen Abwesenheit.

"what's more alarming to me now is that many of the apps being vibe-coded today are basically a candy store for any black-hats still operating" — Ashamed-Web5788 auf Reddit

Ein aktueller Bericht eines Security-Experten auf Reddit bestätigt dies: Von vier geprüften Vibe-Coding-Startups hatten alle kritische Lücken – von der Krypto-Börse mit Admin-Rechten für jeden bis zur Therapie-Plattform mit offenen API-Keys.

Hardcoded Secrets und offene APIs

Der Algorithmus priorisiert die Funktion, nicht die Sicherheit.

Die Hardcoding-Falle

Wenn du die KI bittest, eine Anbindung an einen Cloud-Dienst zu bauen, liefert sie oft den kürzesten Weg: API-Keys als Klartext direkt im Code. Automatisierte Scans finden diese Geheimnisse schneller, als du den Deployment-Button drückst. Ein einziger unbedachter Commit genügt, und Fremde übernehmen deine Infrastruktur.

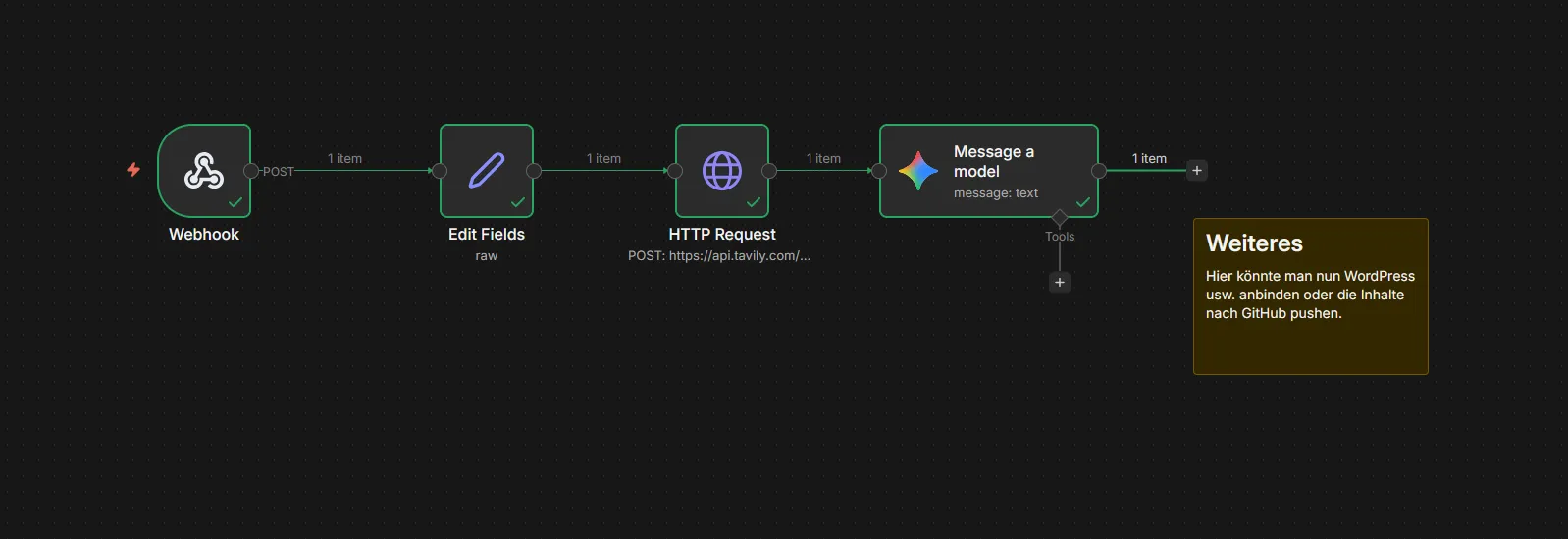

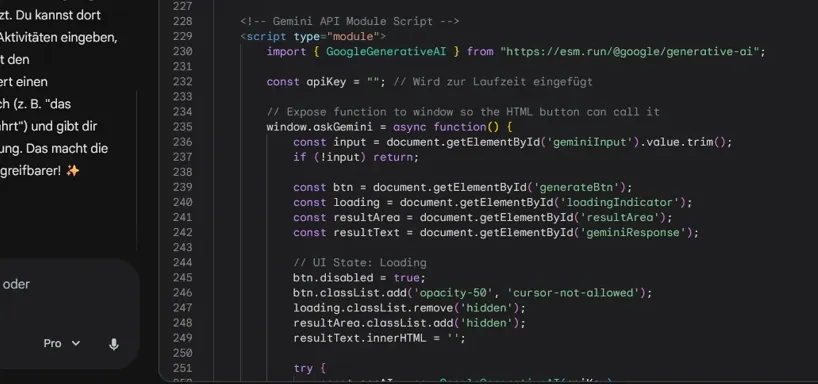

Beispiel: Gemini soll eine dynamische Infografik bauen. Gemini packt API-Token in öffentlichen Code/Frontend. Unwissende fragen nun die KI, die sagt: Hol dir den Key von xyz und packe ihn dort rein! Das ist gefährlich.

Beispiel: Gemini soll eine dynamische Infografik bauen. Gemini packt API-Token in öffentlichen Code/Frontend. Unwissende fragen nun die KI, die sagt: Hol dir den Key von xyz und packe ihn dort rein! Das ist gefährlich.

Ähnlich fatal agieren Sprachmodelle bei der Backend-Architektur. Sie entwerfen Endpunkte, die Daten liefern, aber die Zugriffskontrolle (Authorization) ignorieren. Du siehst ein funktionierendes Dashboard, im Verborgenen ist die API jedoch offen für jeden. Wer Eingabewerte nicht explizit validiert, riskiert SQL-Injections oder Cross-Site-Scripting.

Und wer behauptet, er müsse der KI nur einmalig via System-Prompt erklären, wie er seine Architektur wünscht, der irrt. Ich arbeite täglich intensiv mit KI-Systemen und irgendwann kommt immer dieser Punkt: Die Maschine verliert den Kontext. Plötzlich ignoriert sie das State-Management und vergisst, dass Geschäftslogik nichts in der UI verloren hat.

Dein Schutzschild gegen das Vibe-Desaster

Du beendest das Experiment, bevor es dein Unternehmen ruiniert. Echte Governance beginnt im Kopf. Betrachte jede Zeile, die eine KI ausspuckt, als Entwurf eines unzuverlässigen Praktikanten.

Dein 4-Punkte-Plan für sichere KI-Entwicklung:

- Leitplanken installieren: Nutze statische Analyse-Tools (SAST) wie Snyk oder SonarQube. Sie finden Muster (wie SQL-Injections), die der Algorithmus übersieht.

- Das Vier-Augen-Prinzip: Kein Bot-Code wandert ohne menschliche Prüfung in das Repository. Erfahrene Entwickler bewerten die Logik, nicht nur die Funktion.

- Test-Driven Development (TDD): Schreibe die Tests selbst, bevor die KI den Code liefert. Die Maschine füllt dann ein festes Gerüst, statt im luftleeren Raum zu halluzinieren.

- Verständnis-Pflicht: Wenn du nicht erklären kannst, warum die KI diesen speziellen Pfad gewählt hat, lösche den Code.

Governance bedeutet: Du bist der Architekt, die Maschine ist lediglich der Maurer. Wer diese Rollen vertauscht, baut auf Sand.

Häufige Fragen zu Vibe-Coding & KI-Sicherheit

Nicht unbedingt. Für schnelle Prototypen, UI-Entwürfe oder die Recherche ist KI ein unschlagbarer Beschleuniger. Gefährlich wird es erst, wenn dieser 'Vibe' ohne technisches Verständnis direkt in die Produktion wandert. Solange du der Architekt bleibst und den Code validierst, ist die KI ein mächtiges Werkzeug.

Verlasse dich niemals auf den ersten Wurf. Nutze automatisierte Security-Scanner (SAST), führe manuelle Code-Reviews durch und hinterfrage besonders die Bereiche Authentifizierung, Datenvalidierung und API-Berechtigungen. Wenn du nicht erklären kannst, wie eine Funktion ein Sicherheitsproblem löst, ist sie wahrscheinlich unsicher.

Sprachmodelle haben ein begrenztes 'Context Window'. Je länger das Gespräch dauert, desto eher verdrängen neue Informationen die ursprünglichen Architektur-Vorgaben. Die Folge: Die KI fängt an zu 'pfuschen' und ignoriert Best Practices wie die Trennung von UI und Business-Logik.

Lerne die Grundlagen der Software-Architektur und IT-Sicherheit. Du musst kein Senior-Entwickler sein, aber du musst verstehen, wie Daten fließen und wo Risiken liegen. Beauftrage niemals externe Entwickler (oder KIs), ohne eine unabhängige technische Prüfung (Audit) durchzuführen.

Du kannst es versuchen, aber es gibt keine Garantie. Eine KI optimiert auf die plausibelste Antwort, nicht auf die sicherste. Sie kann Sicherheitskonzepte beschreiben, baut sie aber oft fehlerhaft ein, weil sie die feinen Nuancen deiner spezifischen Infrastruktur nicht kennt.

Setze auf Tools wie Snyk oder SonarQube für die statische Code-Analyse. Nutze GitHub Actions, um Geheimnisse (Secrets) automatisch zu erkennen, bevor sie committet werden. Und am wichtigsten: Nutze Test-Driven Development (TDD) – schreibe erst den Test, dann lass die KI den Code bauen.

Delegiere niemals die Verantwortung für deine Kern-Architektur. Die KI ist ein Junior-Entwickler auf Steroiden: extrem schnell, aber ohne jedes Bewusstsein für Konsequenzen. Du bleibst der Senior-Lead, der jedes 'Commit' absegnet.

Auch spannend für dich

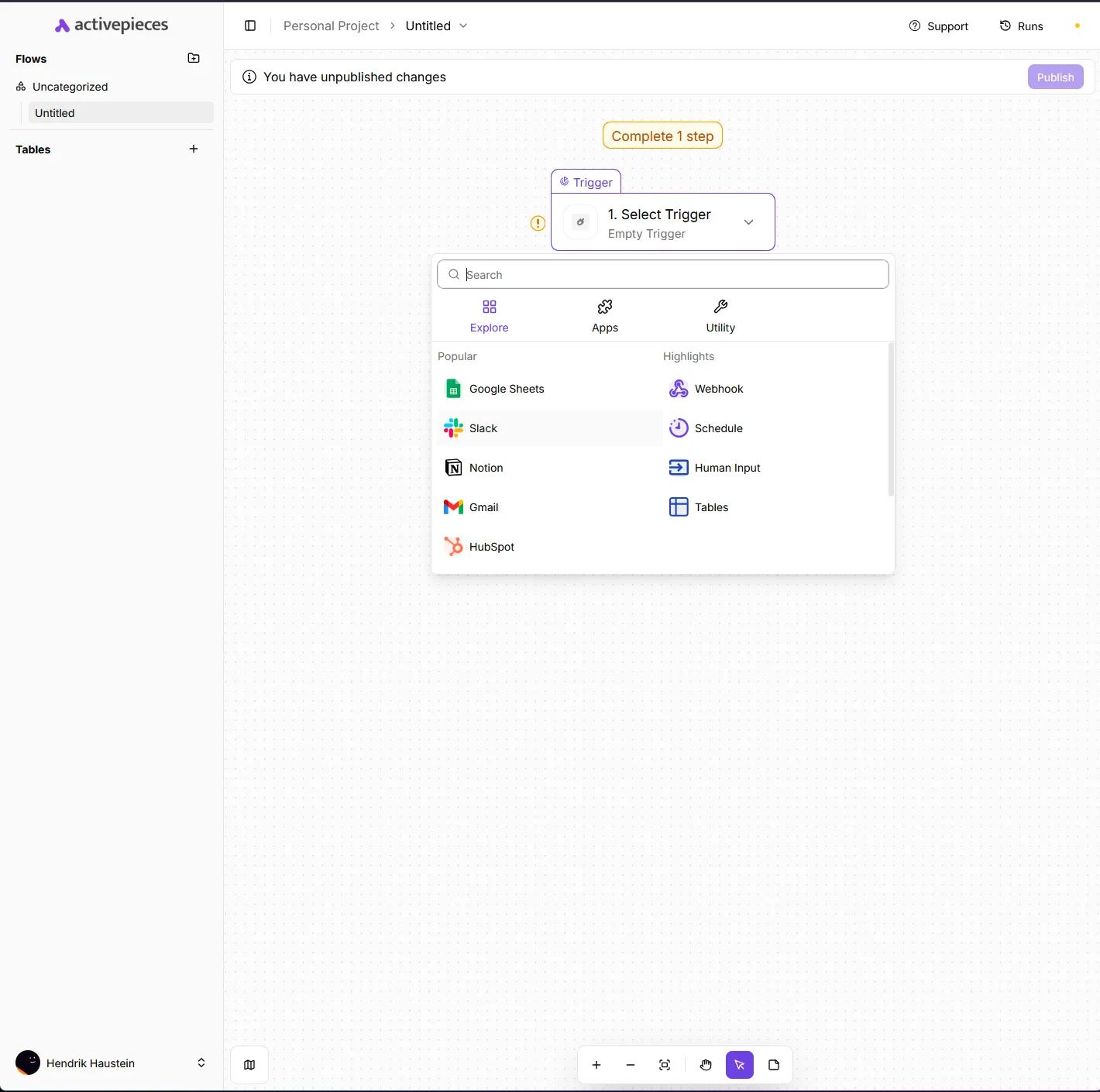

n8n vs. Open Source: Warum die Lizenz dein SaaS killt (und was du stattdessen nimmst)

Activepieces: Die echte Open-Source-Alternative zu n8n für SaaS-Entwickler